Se você perguntasse a um leigo na rua o que ele achava que era um supercomputador, você provavelmente teria uma grande porcentagem citando exemplos de filmes populares e, normalmente, exemplos de reputação duvidosa. Desde o HAL 9000 (2001: Uma Odisséia no Espaço) ao VIKI do iRobot, e até o Skynet do The Terminator; a cultura popular frequentemente se refere a supercomputadores como sistemas conscientes que evoluíram e se voltaram contra a humanidade.

Diga isso aos pesquisadores do Lawrence Livermore National Laboratory, ou do National Weather Service, e eles te expulsarão da sala rindo. A verdade é que hoje os supercomputadores estão longe de ser autoconscientes e a única IA é essencialmente uma barra de pesquisa superinflada que está varrendo grandes conjuntos de dados.

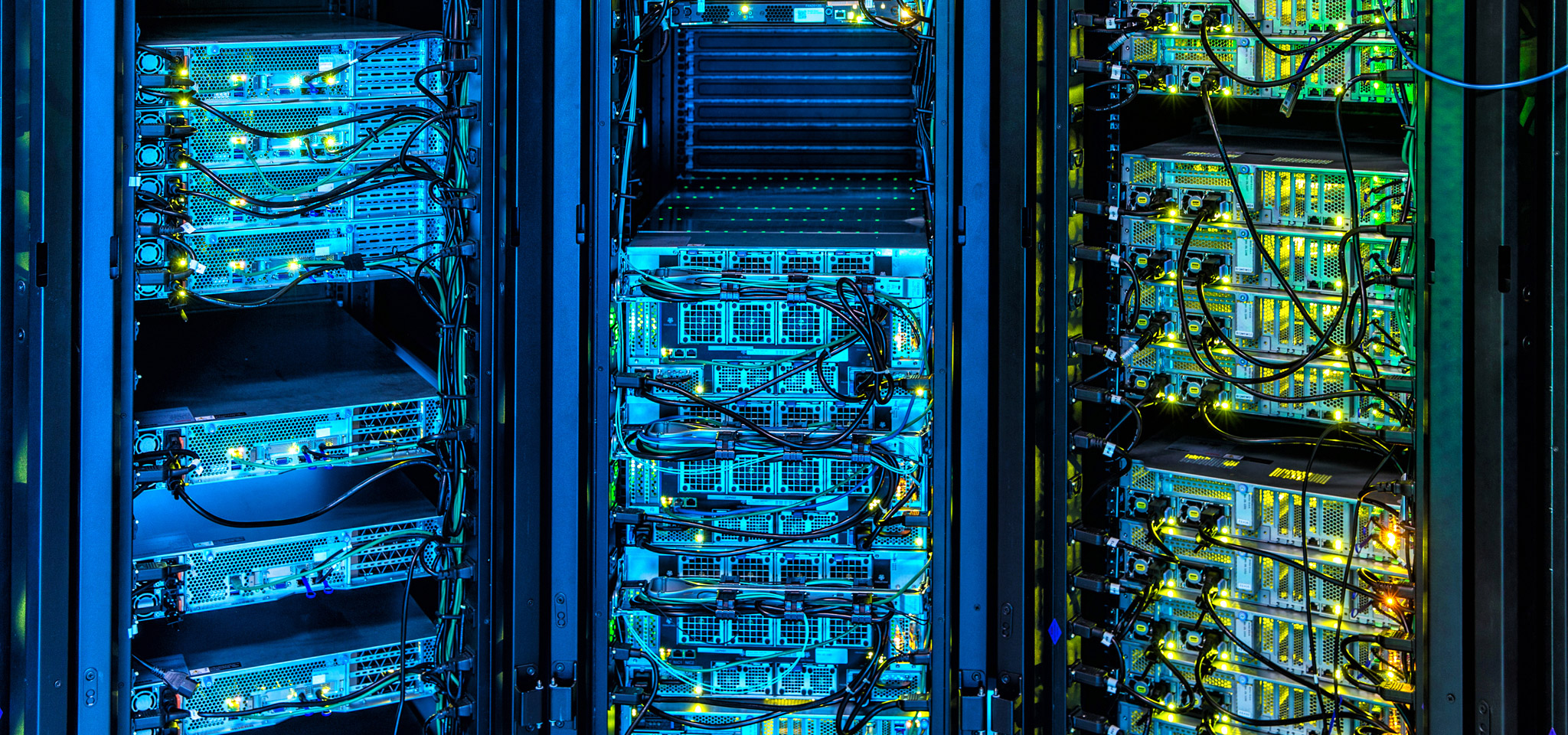

Hoje, os supercomputadores estão alimentando uma grande quantidade de aplicativos que estão na linha de frente do progresso: desde exploração de gás e petróleo a previsões do tempo, mercados financeiros ao desenvolvimento de novas tecnologias. Os supercomputadores são os Lamborghini ou Bugatti do mundo da informática e, na Kingston, prestamos muita atenção aos avanços que estão estendendo as fronteiras da computação. Da utilização e configuração do DRAM aos avanços de firmware no gerenciamento dos sistemas de armazenamento, até a ênfase na consistência das velocidades de transferência e latência ao invés de valores de pico, nossas tecnologias influenciaram profundamente o avanço da supercomputação.

De forma similar, há muitas coisas que gerentes de data centers na nuvem e no local podem aprender com a supercomputação quando se relaciona a projetar e gerenciar suas infraestruturas, bem como melhor selecionar os componentes que estarão prontos para avanços futuros sem grandes reformulações.