Sokakta herhangi bir kişiye, süper bilgisayarların ne olduğuyla ilgili fikrini sorsaydınız yanıt olarak büyük olasılıkla popüler filmlerden, genellikle de kötü şöhrete sahip alıntı örnekler duyardınız. HAL 9000’den (2001: A Space Odyssey) iRobot’un VIKI’sine, hatta Terminator filmindeki Skynet’e kadar popüler kültür genellikle süper bilgisayarları, zamanla evrim geçirerek insanlığa karşı çalışan, sezgisel sistemler olarak göstermektedir.

Bunu Lawrence Livermore Ulusal Laboratuvarı Ulusal Meteoroloji Servisi’ndeki araştırmacılara söylerseniz, size kahkahalarla gülerler. Gerçekte günümüzün süper bilgisayarları kendi farkına varmaktan çok uzaktırlar ve mevcut tek Yapay Zeka, çok büyük veri setlerini tarayan güçlü bir arama çubuğudur.

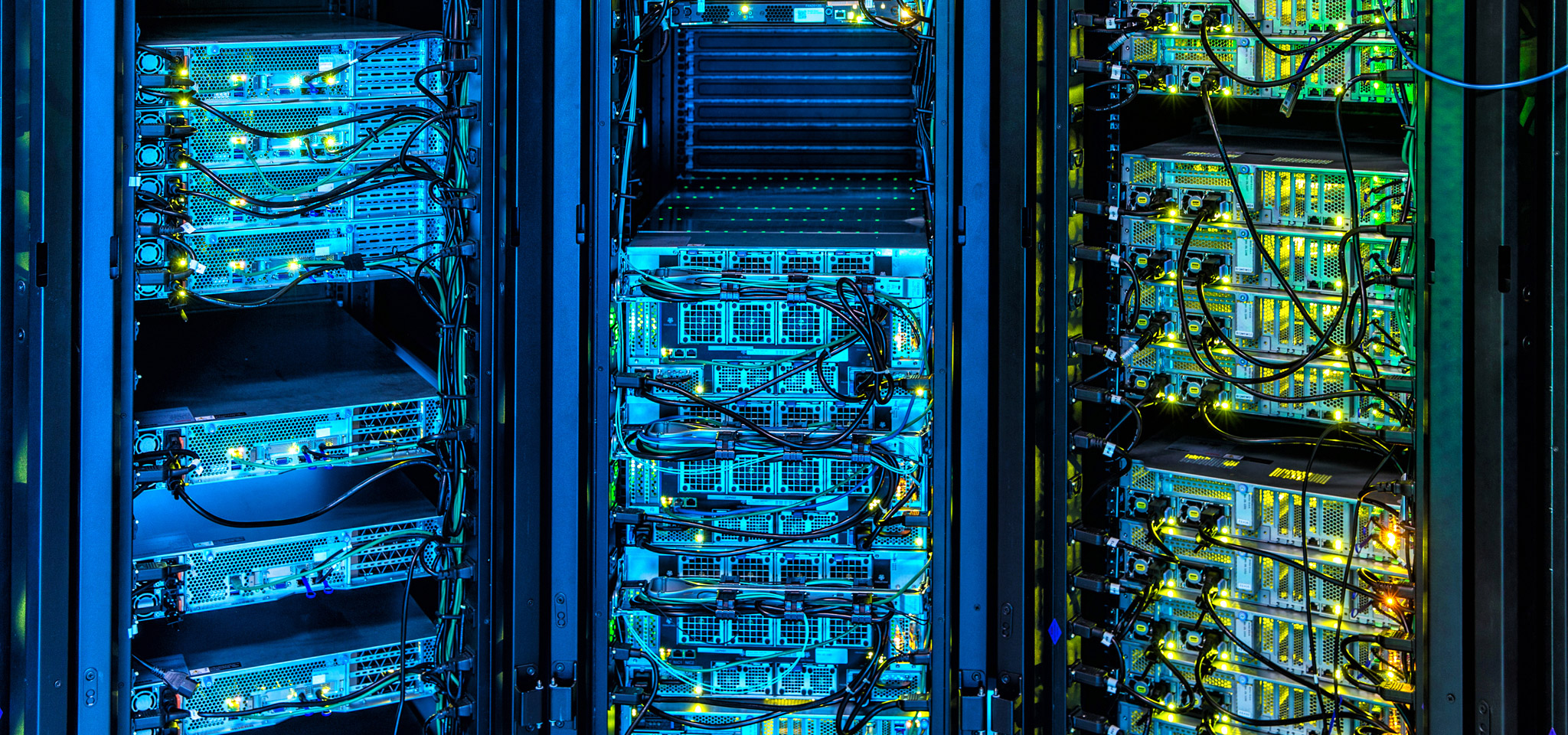

Günümüzde süper bilgisayarlar, ilerlemenin ön saflarında yer alan çok sayıdaki uygulamaya güç vermektedir: Bunlar arasında petrol ve gaz aramalarından hava durumu tahminlerine, finansal piyasalardan yeni teknolojilerin geliştirilmesine kadar birçok örnek sayılabilir. Süper bilgisayarlar, bilgisayar dünyasının Lamborghini ya da Bugatti’sidir. Kingston olarak bilgisayar sistemlerinin sınırlarını zorlayan gelişmelere çok dikkat ediyoruz. DRAM kullanımı ve ayarlamadan veri depolama dizelerinin yönetiminde donanım yazılımına (bellenim sürümü), hatta uç değerler yerine transfer ve gecikme hızlarının tutarlılığına gösterilen öneme kadar teknolojilerimiz, süper bilgisayarların gelişen yanından önemli ölçüde etkilenmektedir.

Benzer şekilde bulut ve tesis içi veri merkezi yöneticilerinin, altyapılarının tasarlama, yönetme ve aynı zamanda büyük revizyonlara ihtiyaç duymadan gelecekteki ilerlemelere hazır olacak bileşenlerin en iyi nasıl seçilebileceğiyle ilgili süper bilgisayarlardan öğrenebileceği birçok konu bulunmaktadır.