如果在路上隨機詢問路人對於超級電腦的看法,您可能會得到很多引用賣座電影的舉例,而且通常不是什麼正面的形象。 從《2001 太空漫遊》(2001: A Space Odyssey) 的HAL 9000 到《機械公敵》(iRobot) 的 VIKI,甚至是《魔鬼終結者》(The Terminator) 的 Skynet;流行文化經常將超級電腦描繪成進化並背叛人類的機器。

如果和在勞倫斯利佛摩國家實驗室 (Lawrence Livermore National Laboratory) 或美國國家氣象局 (National Weather Service) 工作的研究員談起這些例子,他們會哄堂大笑。 老實說現在超級電腦離擁有自我意識還非常遙遠,唯一的人工智慧 (AI) 本質上是一個非常大的搜尋器,負責在數量極為龐大的資料庫搜尋所需的資訊。

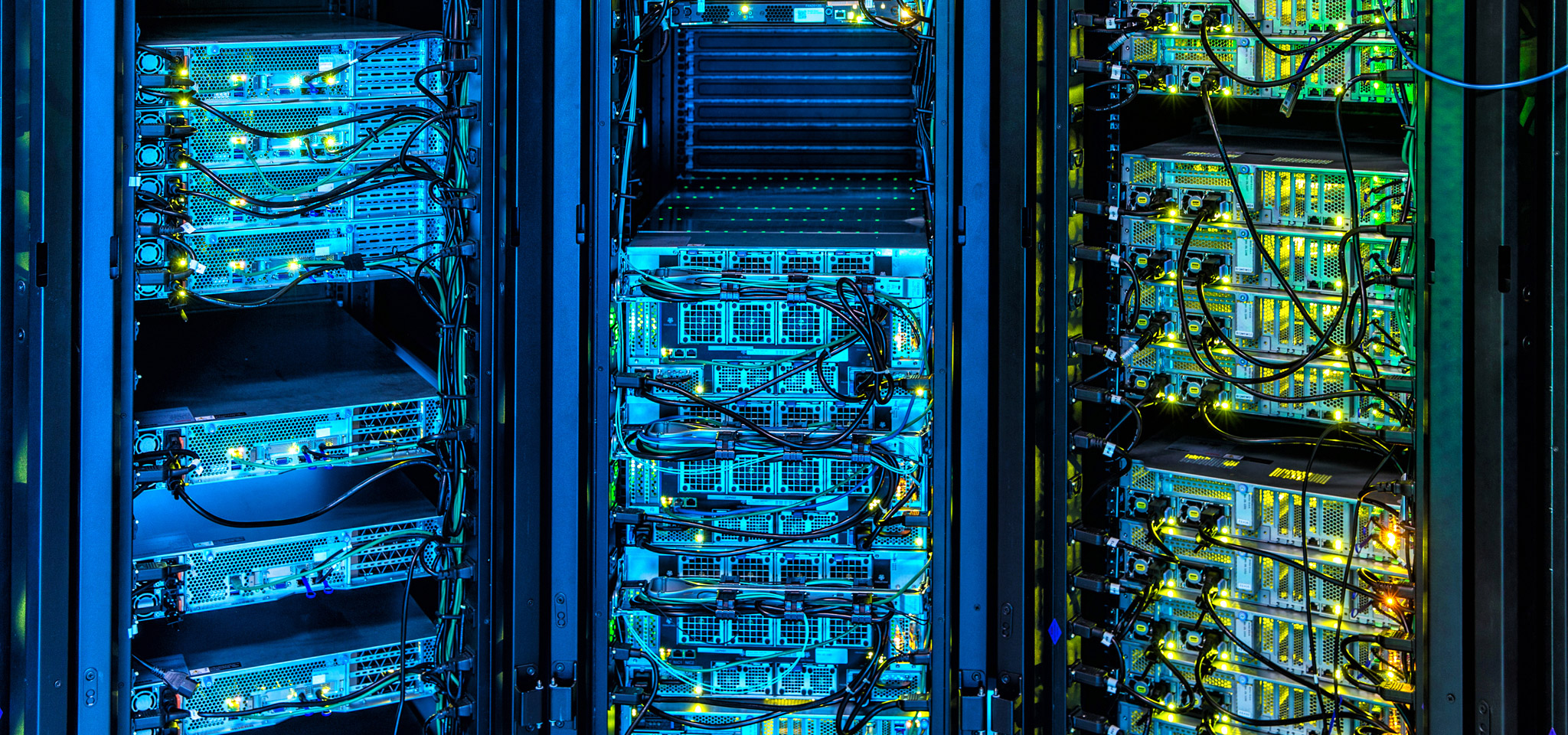

目前超級電腦的用途在於協助研究發展最前沿的眾多應用程式:從石油、天然氣探勘到天氣預報、金融市場以及開發新科技。 超級電腦是運算界的藍寶堅尼或布加迪跑車,而 Kingston投入了許多心血推動運算技術的進步。 從使用與調整 DRAM 到管理儲存陣列的韌體精進工作,甚至是強調傳輸一致性與延遲速度而非高峰值,我們的科技深受還是新興技術的超級運算所影響。

同樣地,雲端與內部部署資料中心管理員也能在設計與管理基礎架構時學到非常多事,還有為將來發展做好準備的元件制定最佳選擇,同時免於進行大幅修改。