La possibilité d'augmenter la performance de l'interface SATA a ralenti l'adoption de la technologie NVMe dans la majorité des datacenters. Il est plus facile d'augmenter la capacité ou de renforcer la performance à l'aide d'une valeur IOPS supérieure ou d'une latence inférieure quand vous utilisez une norme aussi lente que SATA. À l'heure actuelle, la majorité des architectes de datacenter se concentre sur l'amélioration de l'utilisation des CPU. Même avec une baie remplie de CPU coûteux (peu importe le nombre de cœurs ou les frais de licence), les datacenters parviennent rarement à utiliser les CPU ne serait-ce qu'à trente pour cent de leur capacité maximale.

Imaginez que vous avez payé pour une salle de serveurs remplie de Ferrari et que vous ne pouvez pas rouler à plus de 32km/h. La comparaison dans ce cas n'est pas entre Ford et Ferrari, mais bien entre essence sans plomb et essence à indice d'octane élevé.

Le protocole NVMe introduit des changements au niveau des vitesses de transfert et de l'approvisionnement en mémoire, ce qui permet de doubler l'utilisation et de passer de trente à près de soixante pour cent. En exploitant l'infrastructure actuelle, NVMe renforce l'efficacité des CPU par le biais de la réduction de la latence et de l'augmentation du débit. Toutefois, vous devez être en mesure d'accueillir les NVMe. Vos cartes d'insertion actuelles peuvent imposer certaines limites, tout comme l'impossibilité de remplacer votre facteur de forme actuel par un simple branchement. Dans ce cas, les modifications à réaliser sont plus importantes.

Pour pouvoir abandonner un système SAS, il faut modifier l'architecture du serveur, sauf si vous décidez d'utiliser un adaptateur pour pouvoir brancher les SSD NVMe sur le bus PCIe. Cela représentera un changement de plateforme complet pour un client. À la différence des contrôleurs d'hôte matériels SATA et SAS, PCIe est une interface à définition logicielle qui garantit une efficacité supérieure pour les processus dédiés. Il est remarquable de voir que le protocole NVMe garantit une faible latence et la capacité des CPU à pratiquer le multithread.

La question que vous pourriez vous poser maintenant est de savoir ce qui compte le plus aujourd'hui ? Mettre à niveau toute la voiture ou seulement lui donner un moteur plus puissant ?

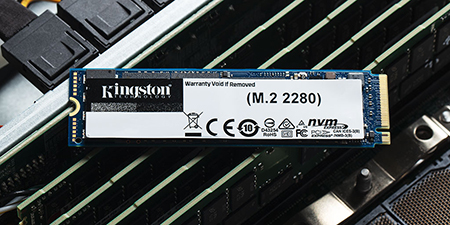

Pour la majorité des responsables de datacenter, le changement va être progressif et débutera par de légères mises à niveau comme les SSD DC1500M et DC1000B de Kingston.