Si le preguntara a un novato en la calle qué cree que es una supercomputadora, probablemente obtendría un gran porcentaje citando ejemplos de películas populares y, por lo general, ejemplos con una reputación infame. Desde HAL 900 (2001: odisea del espacio) hasta VIKI de iRobot e incluso Skynet de Terminator; La cultura pop a menudo hace referencia a las supercomputadoras como sistemas sensibles que han evolucionado y se han vuelto contra la humanidad.

Si le cuenta esto a los investigadores del Laboratorio Nacional Lawrence Livermore, o al Servicio Meteorológico Nacional, y ellos se reirán de usted. La verdad, es que las supercomputadoras de hoy están lejos de ser conscientes de sí mismas, y la única IA es esencialmente una barra de búsqueda exagerada que está escaneando conjuntos de datos muy grandes.

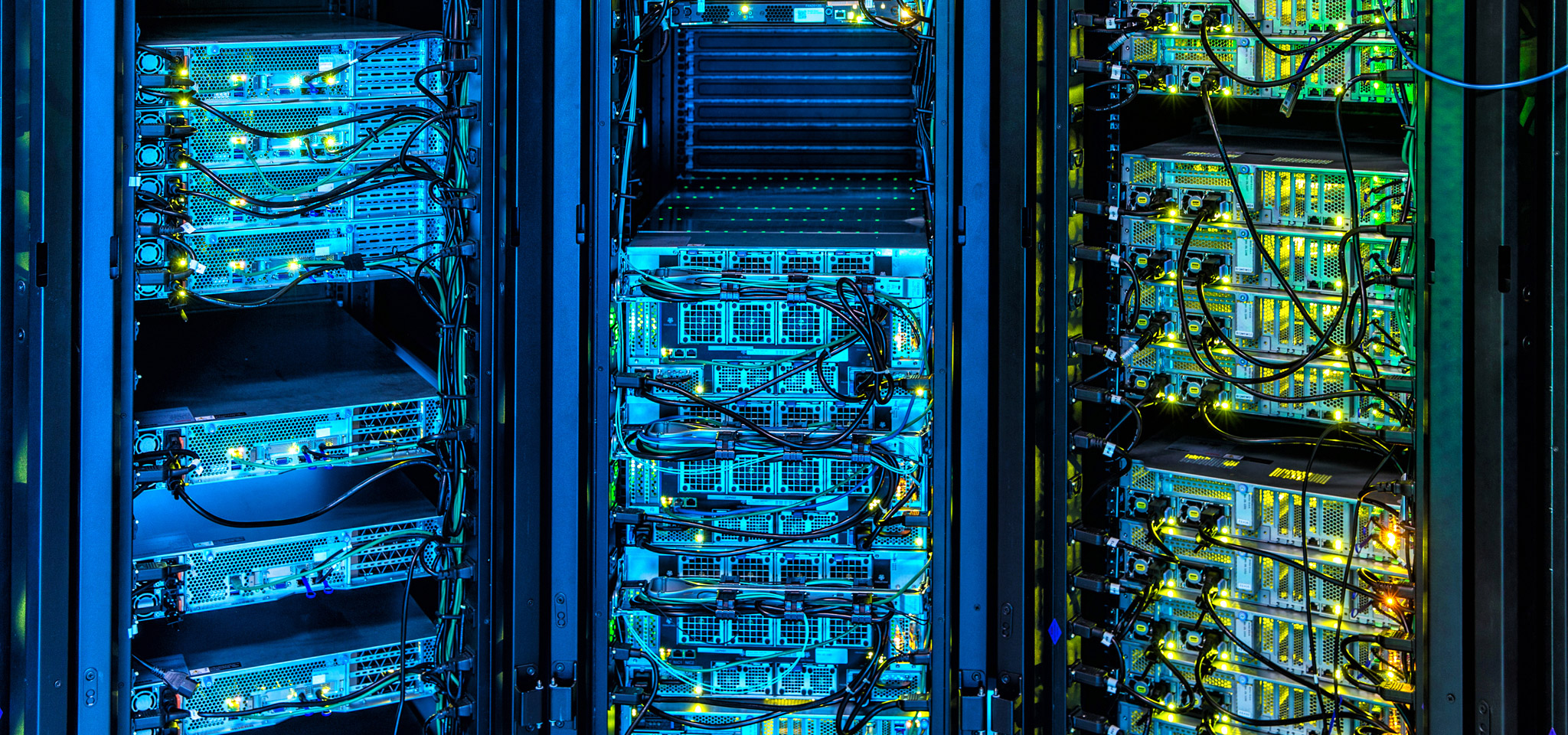

Hoy en día, las supercomputadoras están impulsando una multitud de aplicaciones que están a la vanguardia del progreso: desde la exploración de petróleo y gas hasta las predicciones meteorológicas, los mercados financieros y el desarrollo de nuevas tecnologías. Las supercomputadoras son los Lamborghini o Bugatti del mundo de la informática, y en Kingston, prestamos mucha atención a los avances que están empujando los límites de la informática. Desde la utilización y el ajuste de DRAM, hasta los avances de firmware en la administración de matrices de almacenamiento, incluso en el énfasis en la consistencia de la transferencia y las velocidades de latencia en lugar de los valores máximos, nuestras tecnologías están profundamente influenciadas por la vanguardia de la supercomputación.

Del mismo modo, hay muchas cosas que los administradores de centros de datos en la nube y locales pueden aprender de la supercomputación a la hora de diseñar y administrar sus infraestructuras, así como la mejor forma de seleccionar los componentes que estarán listos para futuros avances sin grandes cambios.