Nếu bạn hỏi một người bình thường trên đường xem họ nghĩ một chiếc siêu máy tính là thế nào, có lẽ phần lớn các câu trả lời mà bạn nhận được sẽ nói đến ví dụ từ các bộ phim nổi tiếng và thường là các ví dụ liên quan đến tội ác. Từ HAL 9000 (2001: A Space Odyssey) đến VIKI của iRobot, và thậm chí là Skynet của The Terminator; văn hóa đại chúng thường thể hiện siêu máy tính như là những hệ thống hữu tình đã tiến hóa và chống lại loài người.

Nếu bạn nói điều đó với các nhà nghiên cứu tại Phòng thí nghiệm Quốc gia Lawrence Livermore hay Cục Khí tượng Quốc gia, họ chắc chắn sẽ cười phá lên cho xem. Sự thật là ngày nay các siêu máy tính còn lâu mới có khả năng tự nhận thức và AI, về cơ bản, chỉ là một thanh tìm kiếm được thổi phồng là đang quét những tập dữ liệu rất lớn.

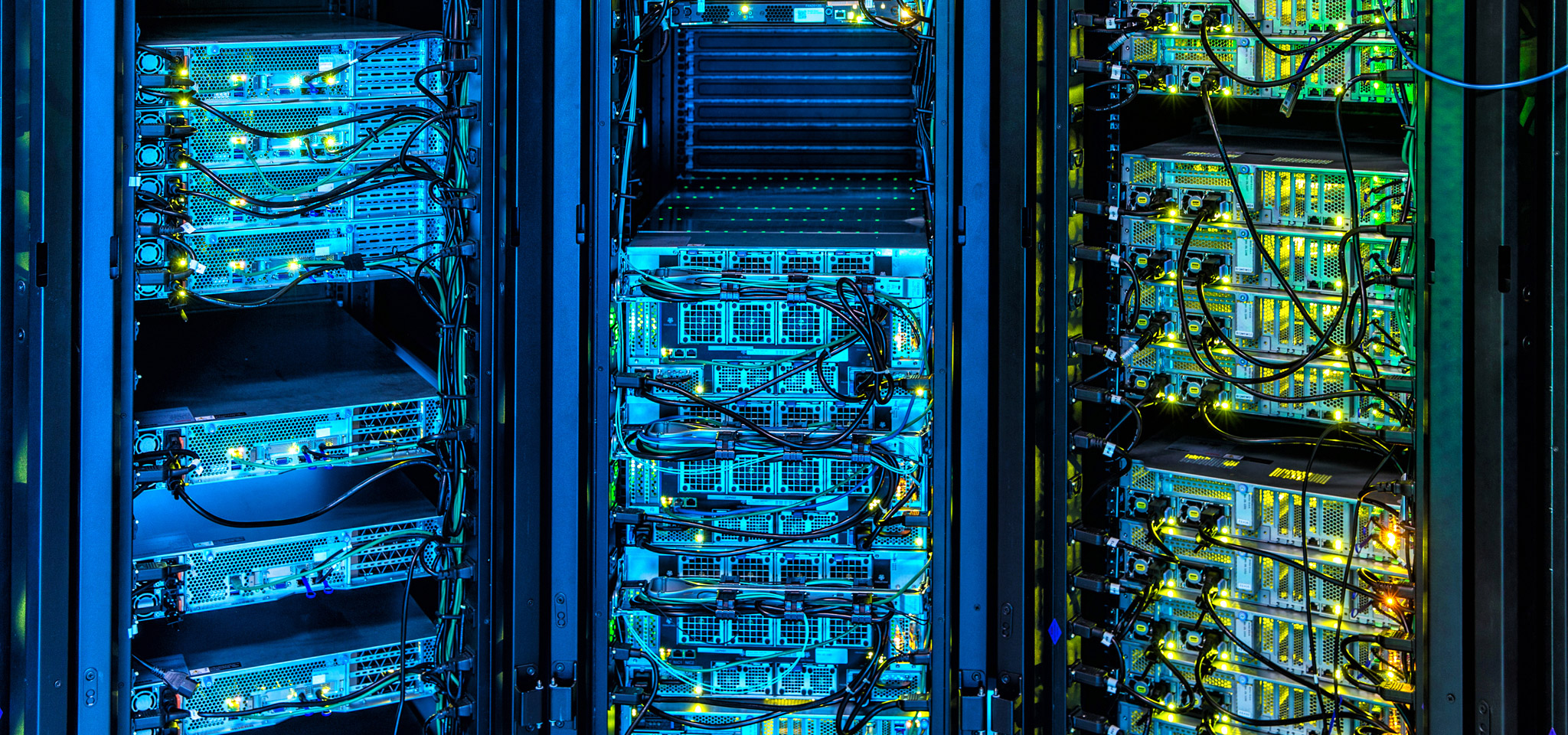

Ngày nay, các siêu máy tính đang hỗ trợ rất nhiều các ứng dụng đi đầu về sự tiến bộ: từ việc thăm dò dầu khí đến dự báo thời tiết, thị trường tài chính đến phát triển các công nghệ mới. Siêu máy tính là những chiếc Lamborghini hay Bugatti của thế giới điện toán, và tại Kingston, chúng tôi rất quan tâm đến những tiến bộ đang ngày càng mở rộng các giới hạn tính toán. Từ việc tận dụng và tinh chỉnh DRAM đến những tiến bộ về firmware trong việc quản lý mảng lưu trữ, đến thậm chí là sự nhấn mạnh vào tính ổn định của tốc độ truyền và độ trễ thay vì các giá trị tối đa, các công nghệ của chúng ta chịu ảnh hưởng sâu sắc của siêu máy tính tối tân.

Tương tự vậy, có rất nhiều điều mà các nhà quản lý trung tâm dữ liệu đám mây và tại chỗ có thể học hỏi từ siêu máy tính khi nói đến thiết kế và quản lý hạ tầng của họ, cũng như cách tốt nhất để chọn các linh kiện sẽ sẵn sàng cho các tiến bộ trong tương lai mà không phải đổi mới nhiều.