Demandez à un expert des disques SSD Serveur

Pour planifier la bonne solution, les objectifs de votre projet de sécurité doivent être clairement définis. Les experts de Kingston Technology sont là pour vous aider.

Demandez à un expert.

Pour certains professionnels de l'informatique, les disques à semi-conducteurs (SSD) prêtes à confusion. Certains ont l'impression qu'ils sont tous créés égaux, sans réelle différence entre eux, car ils ne contiennent que de la mémoire flash. Ce n'est pas le cas.

La façon dont un SSD est conçu pour des machines clientes, type ordinateur portable ou de bureau (un appareil conçu pour les travaux de tous les jours) est très différente de la façon dont un SSD est conçu pour une application de datacentres. Les charges de travail sont très différentes. La charge de travail d'un serveur est généralement de 100 % 24 heures sur 24, 7 jours sur 7, toute l'année. Mais lorsque nous travaillons sur nos ordinateurs individuels tout au long de la journée, ou même sur une machine virtuelle, nous n'utilisons que des ressources minimales avec de longues périodes d'inactivité.

Les disques installés dans un serveur doivent répondre à des demandes constantes et fournir des performances indispensables à des tâches intensives. On ne peut pas simplement prendre le SSD d'un ordinateur portable et s'attendre à ce qu'il fonctionne dans un datacentre. C'est comme s'attendre à ce qu'un moteur de voiture de tourisme puisse déplacer un semi-remorque. Les datacentres ont besoin de disques de qualité professionnelle et spécialement conçus pour offrir des performances prévisibles à leur échelle.

Plus que jamais, les SSD supportent un nombre croissant d'applications spécifiques aux datacentres. Au début, les SSD étaient relativement inconnus. Les services informatiques en avaient même un peu peur. Mais comme cette technologie a mérité leur confiance, les SSD apparaissent de plus en plus dans des secteurs d'applications exigeant de hautes performances. Et c'est dans ces secteurs que la cohérence des performances devient importante.

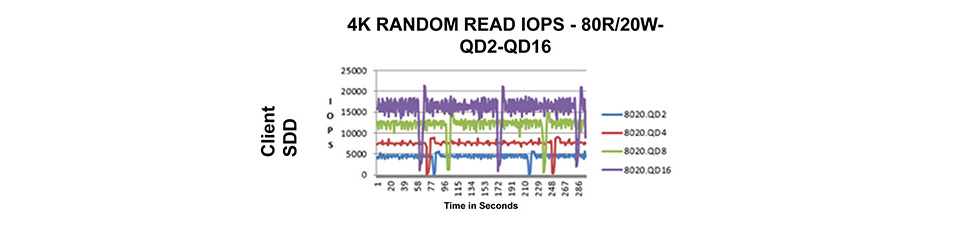

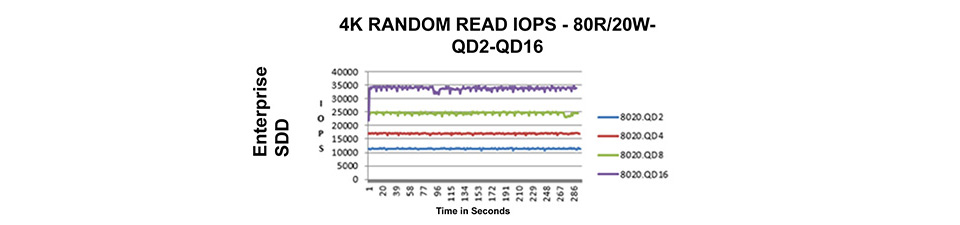

Pour créer des SSD adaptés aux exigences d'un datacentre, la cohérence des performances devient un facteur déterminant, compte tenu de son impact sur les IOPs et les latences. Pour tester cela, des scripts de performance sont créés pour examiner chaque E/S avec un modèle de test de longue durée.

Les fabricants et les architectes informatiques veulent voir des lignes de cohérence rectilignes pendant les tests de référence avec leurs charges de travail. Il n'y a jamais de cohérence parfaite à 100 %, mais il est possible d'éviter des modèles en dents de scie, ce que l'on appelle un modèle "arbre de Noël" sur les E/S, lorsque les analyses des performance sont représentés graphiquement.

Un disque mal réglé peut générer des performances caractérisées par d'importantes variations. À un moment donné, le lecteur peut effectuer 50 000 IOPs, puis il tombe à 20 000 IOPs avant de rebondir à 60 000 IOPs. Bien que les chiffres élevés semblent excellents pour une fiche technique et une documentation commerciale, les pics de performance ne disent pas tout. Les SSD Entreprise de Kingston pour datacentres sont conçus pour fournir des niveaux de performance constants, même si cela peut impliquer de sacrifier certains niveaux de performance de pointe.

Cette cohérence garantit que les clients ne sont pas déçus par le "manque" de performances, mais qu'ils bénéficient en réalité d'un avantage prévisible pour gérer leurs clusters de stockage. Les facteurs requis pour créer ce graphique rectiligne et cette cohérence font partie de la conception du microprogramme des SSD, de la taille de la zone de surprovisionnement et la taille du cache d'écriture.

Grâce à une meilleure prévisibilité, nos clients ont la possibilité de créer des applications en fonction de la cohérence des performances, tout en respectant leurs accords de niveau de service.

Avec autant d'opérations en arrière-plan, par exemple la commande TRIM, l'élimination des données inutilisées et les commandes hôtes, toutes doivent être prises en considération pour concevoir et configurer le microprogramme. Côté matériel, nous utilisons de vastes caches DRAM sur les SSD pour contenir la totalité ou une grande partie de la table de correspondance des unités. Elles servent aussi de tampon d'écriture pour les écritures sur le SSD.

La latence a le même impact que les performances sur les E/S. Par exemple, si la latence est inférieure à 5 ms et monte jusqu'à 500 ms avant de redescendre à 5 ms, il y a un problème, car cette incohérence des performances peut surgir quelque part dans l'application.

Les clients des datacentres sont devenus beaucoup plus sophistiqués au fil des ans. Dans le passé, un fournisseur de disques SSD pouvait leur fournir un bon disque client. Et au moindre problème, il pouvait l'enlever et le remplacer par un autre disque client bon marché. Mais aujourd'hui, les clients des datacentres examinent les SSD sous toutes les coutures, car ils savent que ces incohérences existent et méritent d'être testées.

Les meilleurs SSD Entreprise actuels intègrent des caches DRAM très importants, avec un réglage optimal du microprogramme pour assurer une cohérence maximale. En fait, environ 90 % des facteurs qui lissent les courbes d'analyse font partie du code des microprogrammes. C'est là un des facteurs de différenciation clés des produits Kingston.

Sur le marché actuel, environ 80 % des SSD qui sont mis en service sont encore des SATA (Serial ATA). La norme SATA maintient des taux de transfert relativement rapides et offre une empreinte relativement faible sur la carte mère, ce qui permet de combiner plus de disques avec d'excellents profils RAID.

Actuellement, dans l'industrie du stockage une tendance forte repousse l'interface SATA en faveur de la norme NVMe (mémoire non volatile express) car la NVMe a été conçue spécifiquement et dès le départ pour les SSD à semi-conducteurs. En fait, de nombreuses projections récentes d'analystes suggèrent que dans les deux prochaines années, un changement majeur interviendra dans le monde des serveurs traditionnels. La norme NVMe promet déjà de briser les limitations d'E/S et de latence associées aux interfaces de disques durs traditionnelles.

Depuis dix ans, les SSD ont été construits avec des interfaces de disques mécaniques. Ce qui semblait parfaitement logique au départ. Mais les experts en stockage savent depuis de nombreuses années qu'il existe une meilleure interface pour les SSD. PCIe est une excellente interface pour les SSD, mais de nombreux serveurs sont aujourd'hui limités dans leur capacité et le nombre de voies disponibles.

Il ne reste qu'un frein. Il ne suffit pas d'appuyer sur un bouton pour migrer une installation sur NVMe.

Les critères de Kingston en matière de cohérence des performances restent les mêmes, qu'il s'agisse de construire une interface SATA ou NVMe. NVMe offre par nature une latence plus faible et de meilleures performances d'entrée/sortie. Par conséquent, les clients attendent évidemment plus de performances d'un disque NVMe.

Pour choisir le bon SSD Entreprise, les datacenters doivent rechercher des SSD qui offrent des latences courtes et qui éliminent les variations excessives sur les E/S.

Enfin, le client doit se demander si son infrastructure est prête à utiliser de nouvelles interfaces de stockage plus rapides. Les SSD jouent un rôle important. Le choix que les clients font pour équiper leurs datacentres devient de plus en plus critique.

#KingstonIsWithYou

Pour planifier la bonne solution, les objectifs de votre projet de sécurité doivent être clairement définis. Les experts de Kingston Technology sont là pour vous aider.

Demandez à un expert.

Il est important de choisir le bon SSD pour votre serveur, car les SSD pour serveurs sont optimisés pour fonctionner à un niveau de latence prévisible alors que les SSD Clients (pour ordinateur de bureau ou portable) ne le sont pas. Ces différences se traduisent par une meilleure disponibilité et une latence plus courte pour les applications et services essentiels.

Cameron Crandall, de Kingston, vous aide à décider si le stockage de vos serveurs sur des SSD NVMe est une solution répondant à vos besoins.

Un SSD est un SSD, n'est-ce pas ? Ce n'est pourtant pas le cas. Il n'est pas rare qu'un SSD grand public soit utilisé à la place de SSD d'entreprise pour des applications qui demandent des charges de travail trop exigeantes et qui mèneront à des SSD usés prématurément.

Certaines entreprises utilisent encore des SSD clients pour gérer les tâches de serveur intenses, puis les remplacent lorsqu’ils ne parviennent pas à maintenir le niveau de performance requis. Découvre pourquoi c’est une fausse économie et comment les SSD de niveau entreprise peuvent augmenter l’efficacité de l’organisation.