Gdyby zapytać przechodniów na ulicy, czym według nich jest superkomputer, prawdopodobnie duży odsetek odpowiedzi wskazywałby przykłady z popularnych filmów, w dodatku o nie najlepszej reputacji. Od HALA 9000 z filmu „2001: Odyseja kosmiczna” po VIKI z produkcji „I, Robot” czy nawet Skynet z „Terminatora” – popkultura często przedstawiała superkomputery jako obdarzone inteligencją emocjonalną systemy, które ewoluując, zwracały się przeciwko ludzkości.

Gdyby powiedzieć o tym badaczom z Lawrence Livermore National Laboratory lub National Weather Service, zareagowaliby gromkim śmiechem. Prawda jest taka, że dzisiejsze superkomputery są dalekie od samoświadomości, a ich jedyną sztuczną inteligencją jest w zasadzie tylko „przerośnięty” pasek postępu wyszukiwania, który ilustruje skanowanie bardzo dużych zestawów danych.

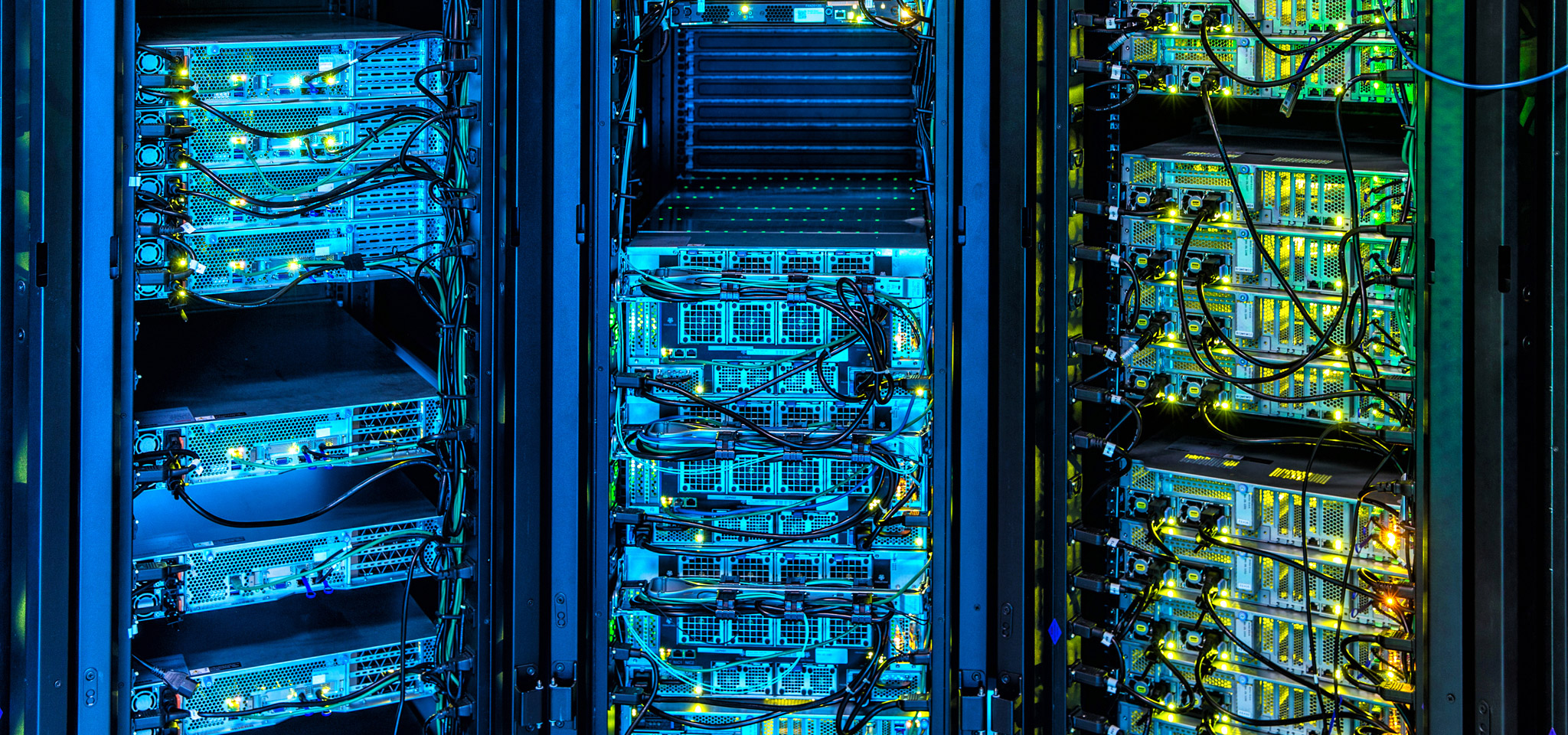

Obecnie superkomputery są wykorzystywane w wielu zastosowaniach, które stoją w awangardzie postępu: poczynając od poszukiwania ropy naftowej i gazu, poprzez prognozy pogody i analizę rynków finansowych, a kończąc na rozwoju nowych technologii. Superkomputery to jak Lamborghini lub Bugatti w świecie komputerowym, a firma Kingston przywiązuje dużą wagę do postępu technologicznego, który przesuwa granice możliwości przetwarzania danych. Od wykorzystania i dostrajania pamięci DRAM, poprzez rozwój oprogramowania układowego do zarządzania macierzami pamięci, po stabilność prędkości przesyłania i opóźnień zamiast wartości szczytowych — nasze technologie mają głęboki wpływ na rozwój technologii superkomputerów.

Podobnie jest wiele rzeczy, których zarządzający centrami danych w chmurze i w oparciu o zasoby lokalne mogą nauczyć się od superkomputerów – zarówno jeśli chodzi o projektowanie infrastruktury i zarządzanie nią, jak i wybór podzespołów, które będą gotowe do przyszłej modernizacji bez konieczności wielkiej przebudowy.