Si preguntásemos a cualquier persona en la calle qué cree que es la supercomputación, posiblemente un alto porcentaje de las respuestas harían referencia a ejemplos de películas populares, y normalmente de pésima reputación. Desde HAL 9000 (2001: Una odisea del espacio) hasta VIKI de Yo, Robot e incluso el Skynet de Terminator, la cultura popular suele considerar a los superordenadores como sistemas sensibles que han evolucionado y se han rebelado contra la humanidad.

Dígaselo a los investigadores del Laboratorio Nacional Lawrence Livermore o del Servicio Meteorológico Nacional, y las carcajadas de burla resultarán sonrojantes. Lo cierto es que los superordenadores de la actualidad están muy lejos de la autoconciencia y, esencialmente, su única IA es una exagerada barra de búsqueda de explora enormes conjuntos de datos.

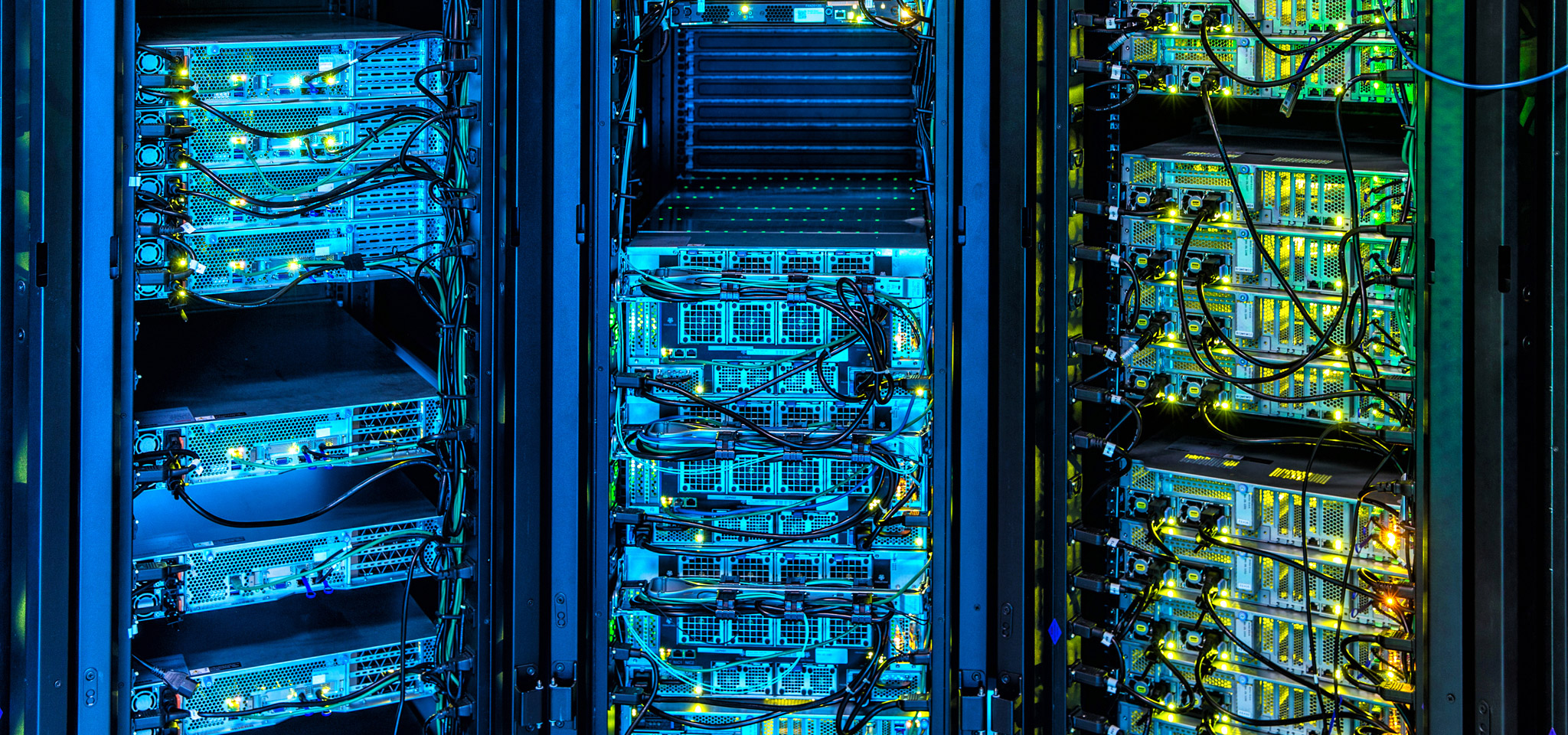

En la actualidad, los superordenadores alimentan multitud de aplicaciones que se sitúan a la vanguardia del progreso: desde la explotación del petróleo y gas hasta los pronósticos meteorológicos, y desde los mercados financieros hasta el desarrollo de nuevas tecnologías. Los superordenadores son los Lamborghini o los Bugatti del mundo informático, y en Kingston prestamos muchísima atención a los avances que amplían las fronteras de la computación. Desde el uso y ajuste de las DRAM hasta los avances en firmware para administrar matrices de almacenamiento haciendo hincapié más en la uniformidad de las velocidades de transferencia y latencia que en los valores máximos, nuestras tecnologías están profundamente influidas por la vanguardia de la supercomputación.

De manera similar, hay muchas cosas que los administradores de centros de datos pueden aprender de la supercomputación a la hora de diseñar y gestionar sus infraestructuras, y también cómo seleccionar mejor los componentes que les permitirán futuros avances sin necesidad de profundas reformas.