La capacidad de mejorar el rendimiento de la interfaz SATA ha provocado que la mayoría de los centros de datos tardasen en adoptar la tecnología NVMe. Es más fácil incrementar la capacidad o el rendimiento mediante más IOPS o menor latencia cuando se utiliza algo lento, como SATA. Si observamos los centros de datos actuales, la mayoría de los arquitectos de los mismos están centrados en intensificar la utilización de las CPU. Con un armario lleno de caras CPU (sean cuales fueren los costes del número de núcleos o de licencias), raras veces los centros de datos son capaces de utilizar las CPU incluso en torno al 30% de su capacidad máxima.

Imagínese tener que pagar por una sala de servidores llena de Ferraris para finalmente tener que conducirlos a 20 km/h. No se trata de una carrera de Ford contra Ferrari, sino más bien una comparación entre combustibles sin plomo y de alto octanaje.

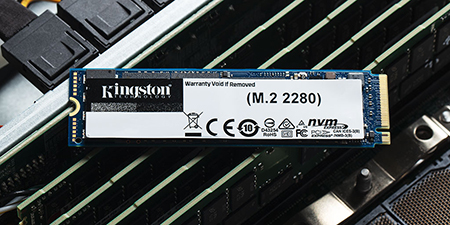

NVMe está propiciando un nuevo cambio, con velocidades de transferencia y provisionamiento en memoria que posibilitan duplicar el grado de utilización desde el 30% hasta prácticamente el 60%. Utilizando las infraestructuras existentes, NVMe permite sacar más partido de las CPU, para que funcionen de manera más eficiente, con menor latencia y mejor rendimiento. Sin embargo, tendría que poder dar entrada a NVMe. Las limitaciones pueden incluir sus actuales placas base o la imposibilidad de insertarlas y sustituirlas por su actual factor de forma. La situación requiere una importante reforma.

Para realizar la transición desde un sistema basado en SAS, es necesario cambiar la arquitectura del servidor, salvo que utilice un adaptador para conectar discos SSD NVMe al bus de PCIe. Para el cliente esto supondrá un cambio integral de la plataforma. En comparación con el uso de controladores de host SATA y SAS basados en hardware, la interfaz PCIe está definida por software y ofrece una mayor eficiencia en los procesos dedicados. Es asombroso cómo NVMe posibilita una baja latencia y permite el procesamiento de las CPU en paralelo.

Entonces, lo más probable es que se pregunte: “¿Qué es más importante hoy? ¿Actualizar el coche entero, o sobrealimentar el motor?”

Para la mayoría de los gerentes de los centros de datos, el cambio va a ser gradual... Empezará por mínimas actualizaciones, como la adopción de las unidades DC1500M y DC1000B de Kingston.