Если бы вы спросили прохожих на улице, что такое, по их мнению, суперкомпьютер, большинство из них, вероятно, ответили бы, ссылаясь на примеры из популярных фильмов — и, как правило, на примеры со скверной репутацией. От HAL 9000 из фильма «2001 год: Космическая одиссея» до VIKI из «Я, робот», и даже до Скайнет из фильма «Терминатор»; поп-культура часто упоминает суперкомпьютеры как разумные системы, которые развились и обратились против человечества.

Расскажите об этом исследователям из Ливерморской национальной лаборатории им. Лоуренса или Национальной метеорологической службы, и они от души посмеются над вами. Правда в том, что современные суперкомпьютеры далеки от самосознания, и единственным ИИ по сути является раздутая панель поиска, которая сканирует очень большие наборы данных.

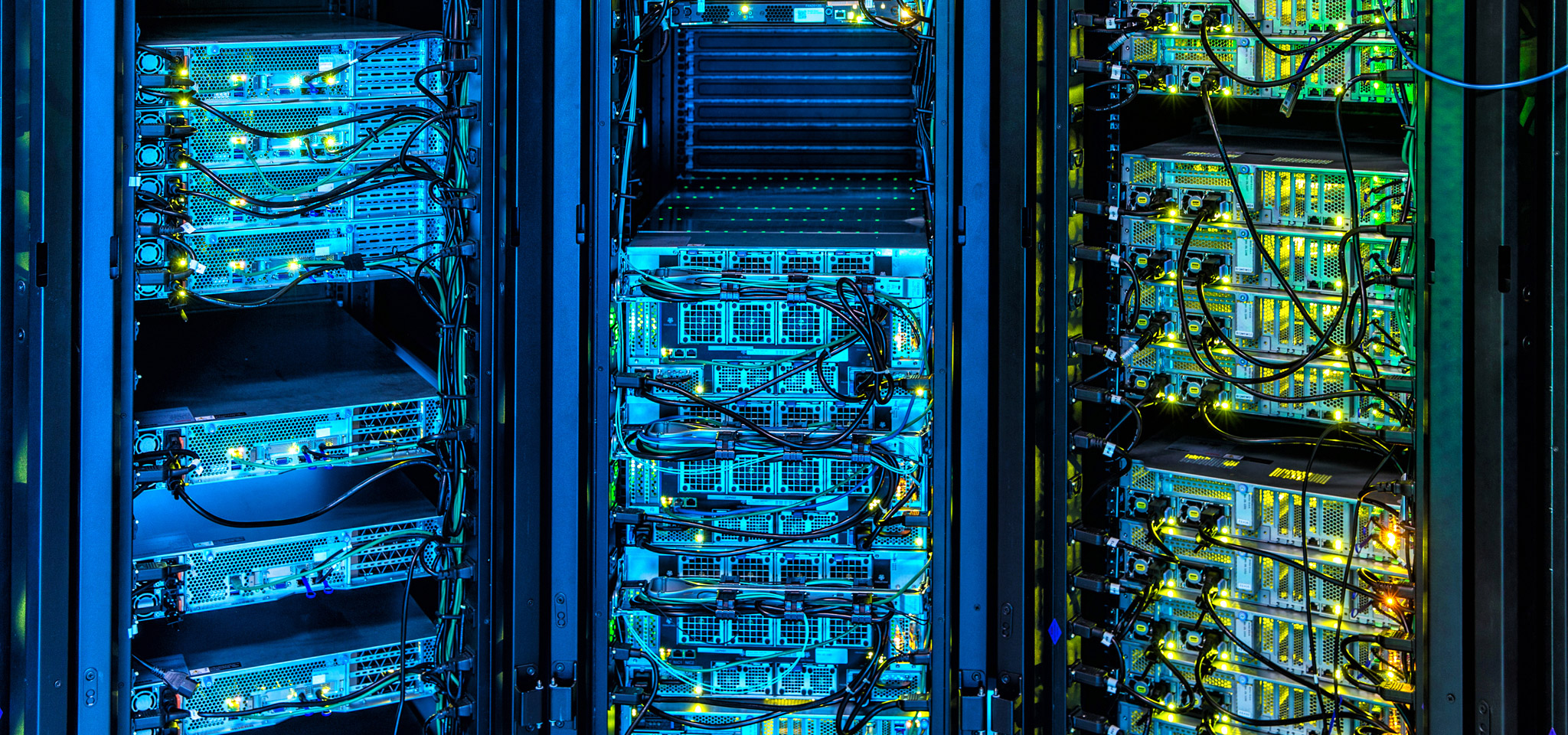

Сегодня суперкомпьютеры имеют множество применений, которые находятся на переднем крае технического прогресса: от поисков месторождений нефти и газа до прогнозов погоды, финансовых рынков и разработки новых технологий. Суперкомпьютеры — это Lamborghini или Bugatti в компьютерном мире, и в компании Kingston мы уделяем большое внимание достижениям, которые расширяют границы компьютерных технологий. От использования и настройки DRAM (dynamic random access memory — динамическая память с произвольным доступом) до усовершенствования микропрограммного обеспечения в управлении массивами хранения данных и даже акцента на согласованность скорости передачи и задержек вместо пиковых значений — ультрасовременные возможности суперкомпьютеров глубоко повлияли на наши технологии.

Аналогичным образом, есть много вещей, которым руководители облачных и локальных центров обработки данных могут научиться у суперкомпьютеров, когда речь заходит о разработке и управлении инфраструктурами, а также о том, как наилучшим образом выбрать компоненты, которые можно будет с легкостью улучшить в будущем без значительных вложений на капитальную реконструкцию.