街頭で一般の方々にスーパーコンピューターについてどう思うか尋ねれば、たぶんほとんどの回答は人気映画に登場した例を挙げるでしょう。たいていの場合は、悪玉です。HAL 9000(2001年宇宙の旅)やアイ,ロボットのヴィキ、またはターミネーターのスカイネットですら、ポップカルチャーで描かれるスーパーコンピューターは、進化して意識を得た結果、人類に敵対したシステムとして描かれることが珍しくありません。

しかし、そうした見方をローレンス・リバモア国立研究所や国立気象局の研究者たちに伝えたら、大声で笑い飛ばされるはずです。現実には、現在のスーパーコンピューターは自意識を持つにはほど遠く、唯一のAIは膨大なデータセットをスキャンする大掛かりな検索バーに過ぎません。

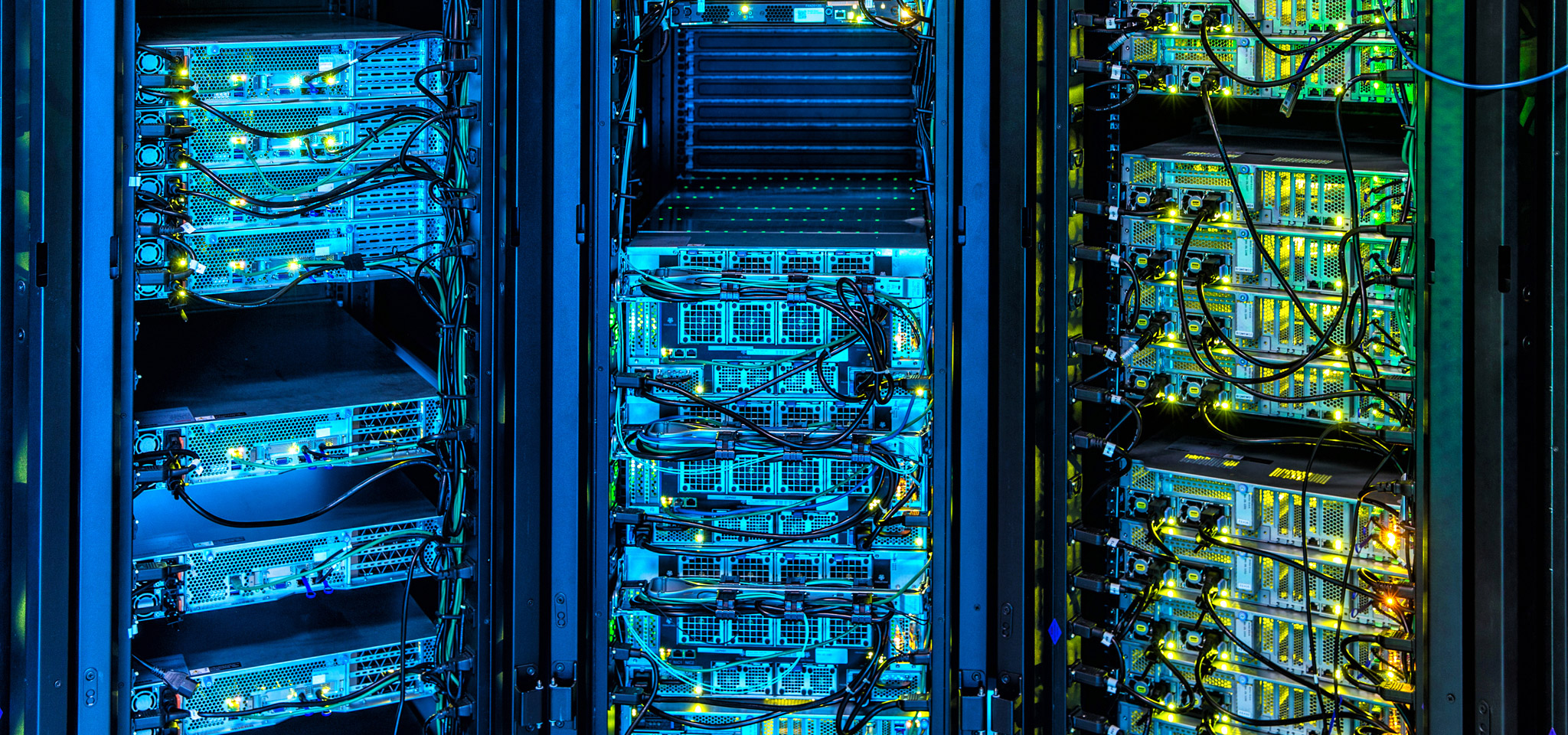

今日、スーパーコンピューターは石油とガスの探索、気象予測、金融市場、新規技術の開発など、発展の最先端で多数のアプリケーションを駆動しています。スーパーコンピューターは、コンピューター分野のランボルギーニやブガッティです。キングストンは、コンピューターの限界を打ち破る進化へ大いに注目しています。DRAMの活用とチューニング、ストレージアレイの管理におけるファームウェアの進歩や、ピーク値ではなく転送とレイテンシの速度の安定性を重要視することにいたるまで、当社の技術は最先端のスーパーコンピューターの影響を深く受けています。

同様に、クラウドまたはオンプレミスのデータセンター経営者は、インフラを設計および管理したり、大規模な設備刷新を行わずとも将来の進歩に対応できるコンポーネントを上手に選択する方法など、多くの事柄をスーパーコンピューターから学べます。